有些领域,领域内风起云涌,让人只觉得天地翻覆,就好像潘朵拉的盒子正在打开,不周山的天柱正在倒塌,每个人都像打了鸡血一样生怕被这股能把猪都吹上天的狂风拉下,可是领域外的人们,面对这个似乎很平静的世界,继续讨论着二十四史中可以用阴谋阳谋把握的故事。

自从2006年hinton提出了对比散度算法以来,从玻尔兹曼机到堆叠自编码器,以google brain项目为起始性事件,微软研究院的机器同时传译,IBM的沃森在危机边缘知识推理问题比赛中击败人类年度总冠军,一时间,先是hinton和其两个学生所开创的dnnresearch公司被收购,接下来hinton另外一名学生所在的没人听说过的deepmind,一个要名声没名声,要产品没产品的公司再次被google以4亿美元收购,接下来,深度学习研究领域另一大牛yuu lecun被facebook实验室收走,李彦宏高调成立百度研究院,并发布少帅计划要向三十岁以下的孩子们发放百万以上年薪。

似乎这一时间,只要沾上了”深度学习”这几个字,立马飞上枝头变凤凰,长成深闺无人见,一朝成名天下知了。。。

深度学习,deep learning,其实就是deep neural netword(即hinton的dnnrearch中的dnn),仍然是神经网络的一枝。而神经网络是一门老技术了,从人工智能成立之日起,神经网络就出现了,只是这门技术命途多舛,其中几经起伏碾转,时而狂风大作,时而门庭冷落,幸好还有hinton大叔之辈,举世非之而不加沮,一直和丫这门技术耗,终于耗到今天重新将之发扬光大。

要八卦神经网络的前世今生,需要从人的大脑皮层开始说起。(吕轻侯:这要从人和宇宙的关系开始讲起。)

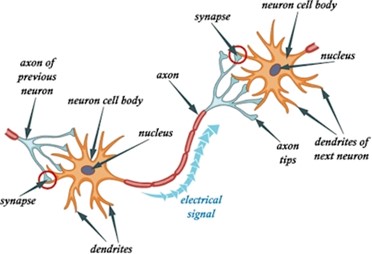

一般意义上来说,被广泛承认的人工智能领域的第一项工作,开始于warren mcCulloch 和 walter pitts,这二人提出了一个简单的神经元模型,即将一个单独的神经元,看成是一个函数,其输入值对应于下层神经元的传导电位,而其输入值则对于对上层神经元的传导电位(此处做了简化处理,实际情况更加地复杂。)

|

|

|

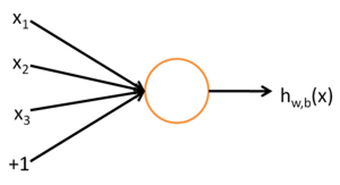

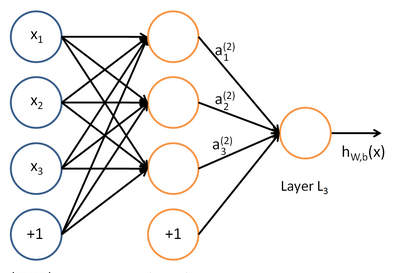

如图,左代表神经元之间的连接,而右边则是简化的数学模型,每条线就代表着一个值的传递,而一个黄圈则代表一个处理函数:而如果把这些神经元,模仿人类的神经元进行联接之后,我们就会得到这样更加复杂的神经元模型(函数)

这其中每一个神经元的输入就仿佛是生物上下层神经元的轴突与本层神经元的树突的联接,而依次类推。

有了这个模型,我们就有了一种较简单的模型来做最基本的砖头,而从这个砖头出发,历代的神经网络研究者们就试图从简到繁,一步一步地来搭建出人类的整个大脑。

这种从简单出发的研究方法,不仅在人工智能领域,同样在神经科学领域也是采取着类似的方法,关于我们的记忆,长期以来也是困扰人类的一个问题,1929年,karl lashley移除活鼠的不同部位,发现其记忆似乎不受影响,因而主张,脑部并没有主管记忆的专区,整个大脑皮层外围都负责记忆动作,然而在这种主张下,医生对病人进行了海马切除手术后,却发现病人的短期记忆转化机制出现明显的问题,病人不再能够记住刚刚发生的事情。

于是lashley的说法遭到质疑,更多的人希望对记忆机制有更深一步的了解,能够搞明白记忆的生理基础。

而最后成功的,则是美国国家健康研究院的Eric Kandel童鞋,Kandel到处思考和寻找,试图设计可行的实验,因为困难在于,对于大脑而言,神经元实在是太小了,然后最后将终于将焦点固定在海蜗牛上面,这种只有两万个神经元的生物,体现比一般蜗牛稍大,就像其他的蜗牛一样,丫会分泌黏液,而分泌的地方,受到刺激就会收缩,小时怕有不少男童鞋们,会拿着一枝尖尖的树枝去刺蜗牛,然后去观察他那种剧烈的收缩。

Kandel对蜗牛进行电击,然后使用行为主义(巴甫洛夫的狗)的方法来对其进行习惯化、敏感化等等,最后成功观察出蜗牛神经连接强度的改变,从而提出记忆的分布式存储理论。

之后我会开始学习神经网络设计一书,在学习过程中,与童鞋们分享我们的仿生学之路。